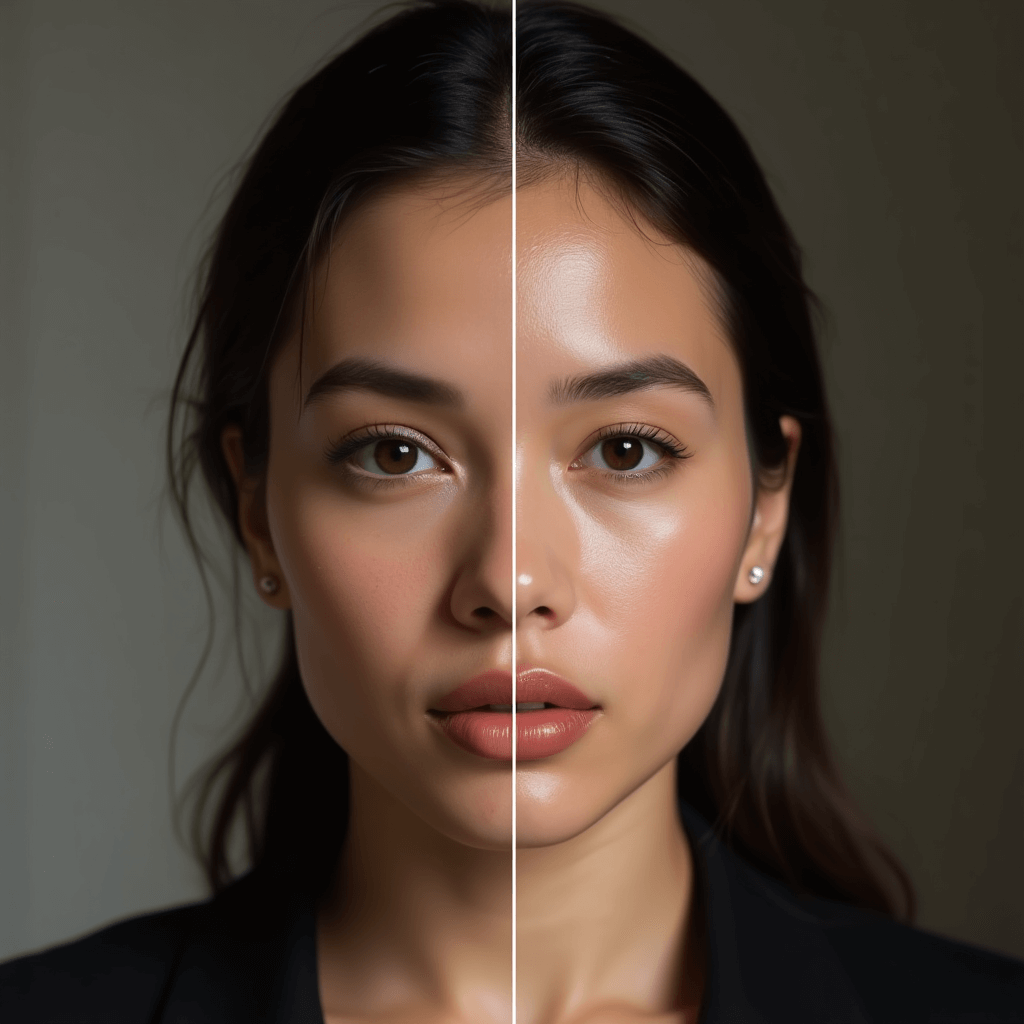

Visages IA : stars méconnaissables, réalité floutée

L’intelligence artificielle franchit un cap troublant. Des visages de célébrités générés par IA trompent désormais même leurs fans les plus fidèles. Cette avancée technologique pose des questions vertigineuses sur notre capacité à distinguer le vrai du faux. La frontière entre réalité et fiction s’estompe dangereusement.

Quand l’IA surpasse la réalité

Les deepfakes ont atteint un niveau de sophistication inédit. Une étude récente menée par des chercheurs britanniques et israéliens révèle un constat alarmant. Les utilisateurs ne parviennent plus à différencier les images authentiques de celles créées par intelligence artificielle. Même lorsqu’il s’agit de personnalités connues, l’œil humain est trompé.

Les universités de Swansea et Lincoln au Royaume-Uni, ainsi que l’université d’Ariel en Israël, ont conduit quatre expériences révélatrices. Elles ont utilisé ChatGPT et Dall-E pour générer des visages de stars. Les résultats sont édifiants. Les participants ont échoué à distinguer les photos réelles des créations artificielles.

Cette performance témoigne des progrès fulgurants de l’IA générative. En trois ans seulement depuis le lancement de ChatGPT, la qualité des images générées a explosé. Ce qui relevait de la science-fiction est devenu banal. Les algorithmes maîtrisent désormais les subtilités des traits humains avec une précision troublante.

La familiarité ne protège plus

L’étude révèle un fait surprenant : connaître une célébrité n’améliore que marginalement la détection. Les fans eux-mêmes sont dupés par ces créations synthétiques. Cette découverte bouleverse nos certitudes sur la reconnaissance faciale humaine. Nous pensions notre mémoire visuelle plus fiable.

Les chercheurs ont fourni des photos de référence à certains participants. Cette aide n’a eu qu’un impact limité. Uniquement, lorsque les sujets étaient clairement informés de l’authenticité des références, leurs performances s’amélioraient légèrement. Cette précision méthodologique souligne la puissance trompeuse de l’IA.

Jeremy Tree, l’un des auteurs de l’étude, exprime son inquiétude. « L’IA peut créer des images synthétiques de visages que la plupart des gens ne peuvent distinguer des photographies réelles. » Cette déclaration met en lumière l’urgence de développer de nouvelles méthodes de détection. La technologie évolue plus vite que nos défenses.

L’IA générative au cœur de la révolution

Pour comprendre cette transformation, il faut saisir le fonctionnement de l’IA générative. Cette technologie ne se contente pas de manipuler des images existantes. Elle crée de toutes pièces des contenus visuels convaincants à partir de simples instructions textuelles. Les modèles comme Dall-E s’appuient sur des millions d’images d’entraînement.

Ces systèmes analysent les caractéristiques photographiques avec une précision microscopique. L’éclairage, les textures de peau, les reflets dans les yeux : chaque détail est reproduit fidèlement. Les imperfections naturelles sont même intégrées pour renforcer le réalisme. L’IA a appris ce qui rend un visage authentiquement humain.

L’accessibilité de ces outils démocratise leur usage. N’importe qui peut désormais générer des visages photoréalistes en quelques secondes. Cette facilité d’utilisation amplifie les risques d’abus. La barrière technique qui limitait autrefois la création de deepfakes a disparu. Une simple requête textuelle suffit maintenant.

Des menaces multiples et concrètes

Les implications de cette technologie dépassent la simple curiosité scientifique. Les chercheurs s’alarment des usages malveillants potentiels. Imaginez une célébrité recommandant un produit qu’elle n’a jamais endossé. Ou soutenant un parti politique qu’elle combat réellement. Ces scénarios ne relèvent plus de la fiction.

Les campagnes de désinformation peuvent exploiter ces deepfakes avec une efficacité redoutable. Une fausse déclaration attribuée à une personnalité influente peut se propager en quelques heures. Le temps que la vérification soit effectuée, le mal est fait. Les réseaux sociaux amplifient ce phénomène de propagation virale.

Le monde du divertissement n’est pas épargné. Des images compromettantes de stars peuvent être fabriquées de toute pièce. La réputation d’une personne peut être détruite par des contenus totalement artificiels. Les victimes se retrouvent impuissantes face à ces attaques numériques sophistiquées. La présomption d’innocence devient illusoire.

L’urgence de nouvelles défenses

Face à cette menace, la nécessité de développer des outils de détection devient prioritaire. Les méthodes traditionnelles d’analyse d’image montrent leurs limites. Les algorithmes de vérification doivent évoluer au même rythme que les techniques de génération. Une course technologique s’engage entre créateurs et détecteurs de deepfakes.

Plusieurs pistes sont explorées par les chercheurs. L’analyse des incohérences microscopiques dans les pixels pourrait révéler l’origine artificielle. Les variations subtiles d’éclairage, imperceptibles à l’œil nu, trahissent parfois la manipulation. Les techniques forensiques numériques se raffinent constamment pour identifier ces signatures.

L’intelligence artificielle elle-même devient un outil de défense. Des réseaux de neurones sont entraînés spécifiquement pour repérer les créations synthétiques. Ce combat entre IA génératrice et IA détectrice promet une escalade technologique sans fin. Chaque amélioration d’un côté entraîne une riposte de l’autre.

Repenser notre confiance visuelle

Cette situation nous oblige à reconsidérer notre relation aux images. Pendant des décennies, la photographie servait de preuve tangible. « Une image vaut mille mots », dit le proverbe. Cette certitude appartient désormais au passé. Nous entrons dans une ère de scepticisme visuel généralisé.

L’éducation aux médias devient cruciale. Le public doit apprendre à questionner systématiquement l’authenticité des contenus visuels. Vérifier la source, croiser les informations, consulter des fact-checkers : ces réflexes doivent devenir automatiques. La littératie numérique n’est plus optionnelle.

Les plateformes sociales portent une responsabilité majeure. Elles doivent implémenter des systèmes de vérification robustes. Le marquage des contenus générés par IA pourrait constituer une première étape. Mais cette mesure suppose une coopération entre développeurs d’IA et réseaux sociaux. Un cadre réglementaire international semble incontournable.

Un défi éthique et juridique

Les implications légales de cette technologie restent floues. Comment poursuivre l’auteur d’un deepfake diffamatoire ? Les lois sur la diffamation s’appliquent-elles aux images synthétiques ? Ces questions juridiques complexes nécessitent des réponses urgentes. Le droit peine à suivre le rythme de l’innovation technologique.

La propriété de l’image pose également problème. Une célébrité peut-elle interdire la génération de son visage par IA ? Le droit à l’image s’étend-il aux représentations artificielles ? Ces zones grises juridiques ouvrent la porte à tous les abus. Les législateurs doivent clarifier le cadre légal rapidement.

L’éthique de la recherche en IA est interpellée. Faut-il limiter le développement de technologies aussi facilement détournables ? Peut-on imposer des garde-fous aux modèles génératifs ? Ce débat oppose liberté de recherche et responsabilité sociétale. L’équilibre reste à trouver entre innovation et protection.

Conclusion : naviguer dans le brouillard numérique

Les visages IA ont franchi le seuil de l’indiscernable. Cette prouesse technique constitue simultanément une menace civilisationnelle. Notre capacité collective à discerner le vrai du faux est érodée. Les deepfakes de célébrités ne sont que la partie émergée de l’iceberg.

La solution ne viendra pas d’une seule innovation. Elle nécessitera une combinaison de technologies de détection, de régulations légales et d’éducation du public. Chaque acteur doit prendre sa part de responsabilité. Les développeurs, les plateformes, les législateurs et les citoyens ont un rôle à jouer.

L’avenir de notre relation à la réalité visuelle se joue maintenant. Les décisions prises aujourd’hui façonneront notre capacité à faire confiance demain. Dans ce monde où les apparences deviennent trompeuses, la vigilance devient notre meilleure alliée. La technologie a créé ce problème ; elle devra contribuer à le résoudre.